[ad_1]

Un nuovo approccio all’informatica potrebbe raddoppiare la velocità di elaborazione di dispositivi come telefoni o laptop senza la necessità di sostituire nessuno dei componenti esistenti.

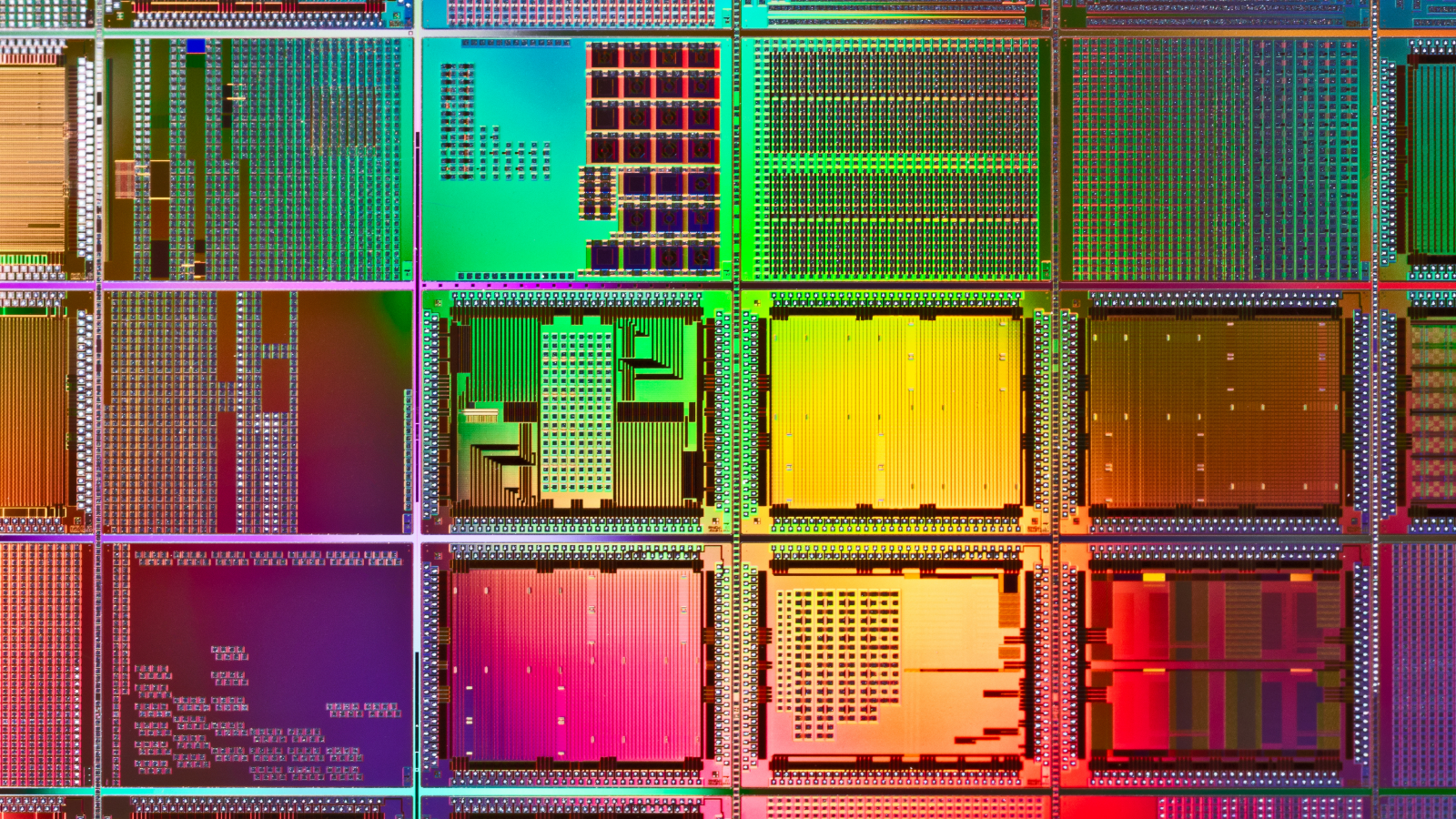

I dispositivi moderni sono dotati di diversi chip che gestiscono diversi tipi di elaborazione. Oltre all’unità di elaborazione centrale (CPU), i dispositivi dispongono di unità di elaborazione grafica (GPU), acceleratori hardware per carichi di lavoro di intelligenza artificiale (AI) e unità di elaborazione del segnale digitale per elaborare i segnali audio.

A causa dei modelli convenzionali di esecuzione dei programmi, tuttavia, questi componenti elaborano i dati di un programma separatamente e in sequenza, il che rallenta i tempi di elaborazione.

Le informazioni si spostano da un’unità a quella successiva a seconda di quale sia più efficiente nel gestire una particolare regione di codice in un programma. Ciò crea un collo di bottiglia, poiché un processore deve completare il proprio lavoro prima di passare una nuova attività al processore successivo in linea.

Imparentato: Il primo PC al mondo riscoperto per caso durante uno sgombero di una casa nel Regno Unito quasi 50 anni dopo l’ultimo avvistamento

Per risolvere questo problema, gli scienziati hanno ideato un nuovo quadro per l’esecuzione del programma in cui le unità di elaborazione lavorano in parallelo. Il team ha delineato il nuovo approccio, denominato “multithreading simultaneo ed eterogeneo (SHMT)” in un articolo pubblicato nel dicembre 2023 sul server di prestampa arXiv.

SHMT utilizza unità di elaborazione simultaneamente per la stessa regione di codice, anziché attendere che i processori lavorino su diverse regioni del codice in una sequenza basata su quale componente è migliore per un particolare carico di lavoro.

Un altro metodo comunemente utilizzato per risolvere questo collo di bottiglia è noto come “pipelining del software” e accelera le cose consentendo a diversi componenti di lavorare su attività diverse contemporaneamente, anziché attendere che un processore finisca prima che l’altro inizi a funzionare.

Tuttavia, nel software pipeline, una singola attività non può mai essere distribuita tra diversi componenti. Questo non è vero per SHMT, che consente a diverse unità di elaborazione di lavorare contemporaneamente sulla stessa regione di codice, consentendo loro anche di assumere nuovi carichi di lavoro una volta che hanno svolto la loro parte.

“Non è necessario aggiungere nuovi processori perché li hai già”, ha affermato l’autore principale Hung-Wei Tsengprofessore associato di ingegneria elettrica e informatica presso l’Università della California, Riverside, ha affermato in a dichiarazione.

Gli scienziati hanno applicato SHMT a un sistema prototipo che hanno costruito con una CPU ARM multi-core, una GPU Nvidia e un acceleratore hardware TPU (tensor Processing Unit). Nei test, ha eseguito le attività 1,95 volte più velocemente e ha consumato il 51% in meno di energia rispetto a un sistema che funzionava in modo convenzionale.

SHMT è anche più efficiente dal punto di vista energetico perché gran parte del lavoro che normalmente viene gestito esclusivamente da componenti a maggiore consumo energetico, come la GPU, può essere scaricato su acceleratori hardware a basso consumo.

Se questa struttura software venisse applicata ai sistemi esistenti, potrebbe ridurre i costi dell’hardware riducendo al tempo stesso le emissioni di carbonio, hanno affermato gli scienziati, perché richiede meno tempo per gestire i carichi di lavoro utilizzando componenti più efficienti dal punto di vista energetico. Potrebbe anche ridurre la domanda di acqua dolce per raffreddare enormi data center, se la tecnologia viene utilizzata in sistemi più grandi.

Tuttavia, lo studio era solo una dimostrazione di un sistema prototipo. I ricercatori hanno avvertito che è necessario ulteriore lavoro per determinare come tale modello possa essere implementato in contesti pratici e quali casi d’uso o applicazioni ne trarranno maggiori benefici.

[ad_2]

Source link