[ad_1]

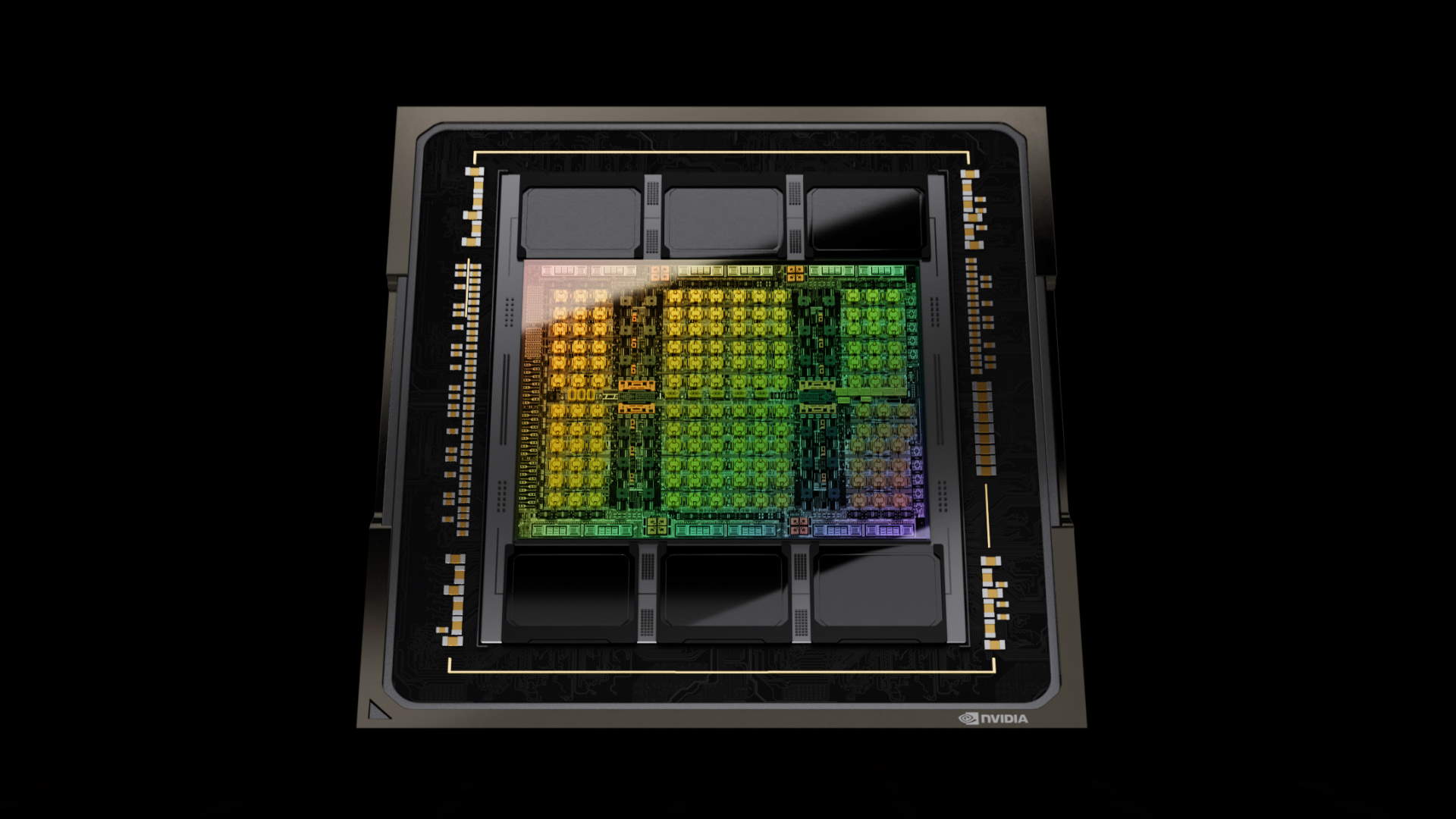

Come probabilmente saprai, c’è una domanda insaziabile di intelligenza artificiale e dei chip di cui ha bisogno per funzionare. Tanto che Nvidia è ora la sesta azienda più grande al mondo per capitalizzazione di mercato, con 1,73 trilioni di dollari al momento in cui scriviamo. Mostra pochi segni di rallentamento, poiché anche Nvidia sta lottando per soddisfare la domanda in questo nuovo mondo dell’intelligenza artificiale. La stampante per banconote fa brrrr.

Per semplificare la progettazione dei suoi chip AI e migliorare la produttività, Nvidia ha sviluppato un Large Language Model (LLM) chiamato ChipNeMo. Raccoglie essenzialmente dati dalle informazioni, dai documenti e dal codice dell’architettura interna di Nvidia per fornirgli una comprensione della maggior parte dei suoi processi interni. È un adattamento di Meta’s Llama 2 LLM.

È stato presentato per la prima volta nell’ottobre 2023 e secondo il Wall Street Journal (tramite Business Insider), finora il feedback è stato promettente. Secondo quanto riferito, il sistema si è rivelato utile per formare ingegneri junior, consentendo loro di accedere a dati, note e informazioni tramite il suo chatbot.

Avendo un proprio chatbot AI interno, i dati possono essere analizzati rapidamente, risparmiando molto tempo ed eliminando la necessità di utilizzare metodi tradizionali come e-mail o messaggistica istantanea per accedere a determinati dati e informazioni. Dato il tempo necessario per una risposta a un’e-mail, per non parlare del fatto che si debbano affrontare diverse strutture e fusi orari, questo metodo sta sicuramente offrendo un gradito aumento della produttività.

Nvidia è costretta a lottare per l’accesso ai migliori nodi di semiconduttori. Non è l’unico ad aprire i libretti degli assegni per l’accesso ai nodi all’avanguardia di TSMC. Mentre la domanda aumenta vertiginosamente, Nvidia fatica a produrre abbastanza chip. Allora perché comprarne due quando puoi fare lo stesso lavoro con uno? Questo aiuta molto a capire perché Nvidia sta cercando di accelerare i propri processi interni. Ogni minuto risparmiato si somma, aiutando l’azienda a immettere sul mercato prodotti più rapidi in tempi più rapidi.

Cose come la progettazione di semiconduttori e lo sviluppo di codice sono perfetti per i LLM AI. Sono in grado di analizzare rapidamente i dati ed eseguire attività dispendiose in termini di tempo come il debug e persino le simulazioni.

Ho menzionato Meta prima. Secondo Mark Zuckerberg (tramite The Verge), Meta potrebbe avere una scorta di 600.000 GPU entro la fine del 2024. Si tratta di un sacco di silicio e Meta è solo una delle aziende. Metti nel mix aziende del calibro di Google, Microsoft e Amazon ed è facile capire perché Nvidia vuole portare i suoi prodotti sul mercato prima. Ci sono montagne di soldi da guadagnare.

A parte la grande tecnologia, siamo ben lontani dal realizzare pienamente gli usi dell’intelligenza artificiale basata sui dispositivi edge nei nostri sistemi domestici. Si può immaginare che l’intelligenza artificiale che progetta hardware e software migliori diventerà sempre più importante e prevalente. Un po’ spaventoso, quello.

[ad_2]

Source link