[ad_1]

All’IEEE International Electron Device Meeting di quest’anno, [IEDM] (Dicembre a San Francisco) SK Hynix ha dato uno sguardo interessante a “Tecnologia di packaging avanzata nelle applicazioni di memoria per la futura era dell’intelligenza artificiale generativa”.

[[L’intelligenza artificiale generativa crea nuovi contenuti attraverso l’uso di modelli di apprendimento automatico come reti avversarie generative. Tali framework utilizzano algoritmi e reti neurali per generare contenuti da zero.

Poiché l’intelligenza artificiale richiede memoria con maggiore larghezza di banda, maggiore capacità e migliore efficienza energetica, SK hynix sta esaminando le sfide che la memoria stacked HBM dovrà affrontare in futuro.

Con l’aumento delle prestazioni del processore, le prestazioni della DRAM diventano un collo di bottiglia nel miglioramento delle prestazioni del sistema, rendendo importante posizionare la memoria più vicino alla logica e collegarla attraverso più percorsi I/O.

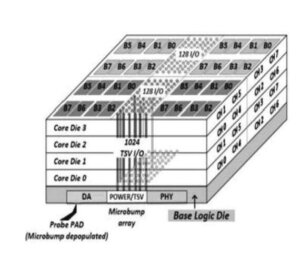

La Figura 1 mostra la struttura fondamentale di SK hynix HBM, costituita da un die logico di base nella parte inferiore e da un die DRAM impilato collegato verticalmente da TSV e microbump.

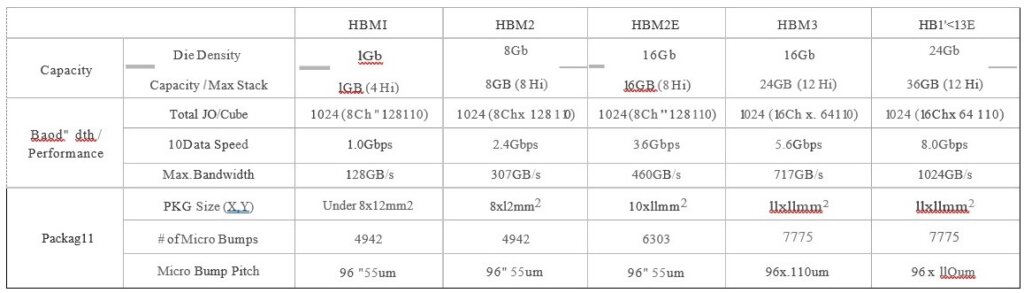

SK hynix ha recentemente annunciato un HBM da 24 GB con uno stack alto da 12 die.

La tabella 1 mostra gli andamenti della larghezza di banda e della capacità per ciascuna generazione HBM. Il passo del TSV e dei microbumps deve essere continuamente ridotto per soddisfare tali requisiti.

Con l’aumento del numero di chip impilati, sono necessari più TSV di potenza e i problemi di erogazione di potenza devono essere risolti. SK Hynix ha scoperto che il calo di potenza migliora notevolmente quando l’energia viene fornita in modo uniforme aggiungendo TSV di potenza all’area del banco e quando le dimensioni dei TSV di potenza aumentano.

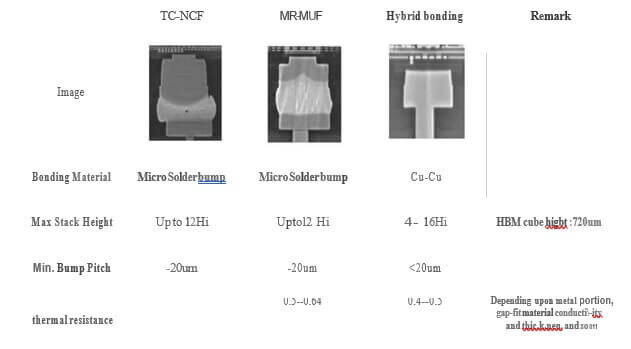

Anche la gestione termica è molto importante. A tal fine, la conduttività termica del materiale di riempimento tra gli strati dovrebbe essere la più alta possibile e dovrebbe essere creato un percorso libero per dissipare il calore.

HBM4 richiede una larghezza di banda corrispondente a una velocità IO di oltre 12 Gbps con 16 o più stack DRAM elevati. Per tali soluzioni, Hynix prevede che il bonding ibrido C2W sia una soluzione migliore poiché impilerà più die in una data altezza Z rimuovendo il materiale di riempimento degli spazi e controllando meglio la dissipazione termica.

Un altro vantaggio del collegamento ibrido è quello di ridurre il passo di interconnessione poiché la giunzione micro-bump non può scendere al di sotto di 20um.

Packaging della memoria AiM e PiM

- Processing-In-Memory (PIM): una tecnologia di prossima generazione che aggiunge capacità computazionali alle memorie a semiconduttore per risolvere il problema della congestione del movimento dei dati nell’intelligenza artificiale e nell’elaborazione dei big data.

- Accelerator in Memory (AiM): nome del prodotto a semiconduttore PIM di SK hynix, che include GDDR6-AiM.

I sistemi GPU esistenti impiegano fino a decine di secondi per generare risposte AI composte da cinque o dieci frasi. Sk hynix rileva che PiM e AiM possono essere soluzioni per superare lunghi tempi di elaborazione e migliorare le prestazioni complessive

GDDR6-AiM è un tipo di chip di memoria che aggiunge funzioni computazionali ai chip di memoria GDDR6, che elaborano i dati a 16 Gbps. Si tratta di una tecnologia di nuova generazione che aggiunge capacità computazionali alle memorie a semiconduttore per risolvere il problema della congestione del movimento dei dati nell’intelligenza artificiale e nell’elaborazione dei big data. SK Hynix ha recentemente presentato e dimostrato un prototipo di AiMX 1, una scheda acceleratrice AI generativa basata su GDDR6-AiM, all’AI Hardware & Edge AI Summit 2023 tenutosi a Santa Clara, California.

La prima applicazione del PIM si chiama GDDR6-AiM. Secondo i test di SK hynix, GDDR6-AiM può velocizzare l’elaborazione dell’intelligenza artificiale fino a 16 volte e ridurre il consumo energetico dell’80%.

Questo primo prodotto PIM si rivolgerà alle applicazioni di machine learning, calcolo ad alte prestazioni e calcolo e archiviazione di big data. Una delle prime applicazioni destinate ad adottare GDDR6-AiM è l’accelerazione dell’elaborazione AI, utilizzando chip sviluppati in collaborazione con SAPEON Inc., recentemente scorporata da SK Telecom (la compagnia telefonica nazionale della Corea del Sud).

I potenziali vantaggi includono il fatto che GDDR6-AiM funziona a 1,25 V, inferiore rispetto ai moduli GDDR5 esistenti (1,35 V). Grazie a questo miglioramento e alla riduzione dello spostamento dei dati tra la memoria e la CPU o GPU, SK Hynix afferma che è possibile ottenere un risparmio energetico fino all’80%.

Per tutte le ultime novità sugli imballaggi avanzati, restate collegati a IFTLE…………………..

[ad_2]

Source link