[ad_1]

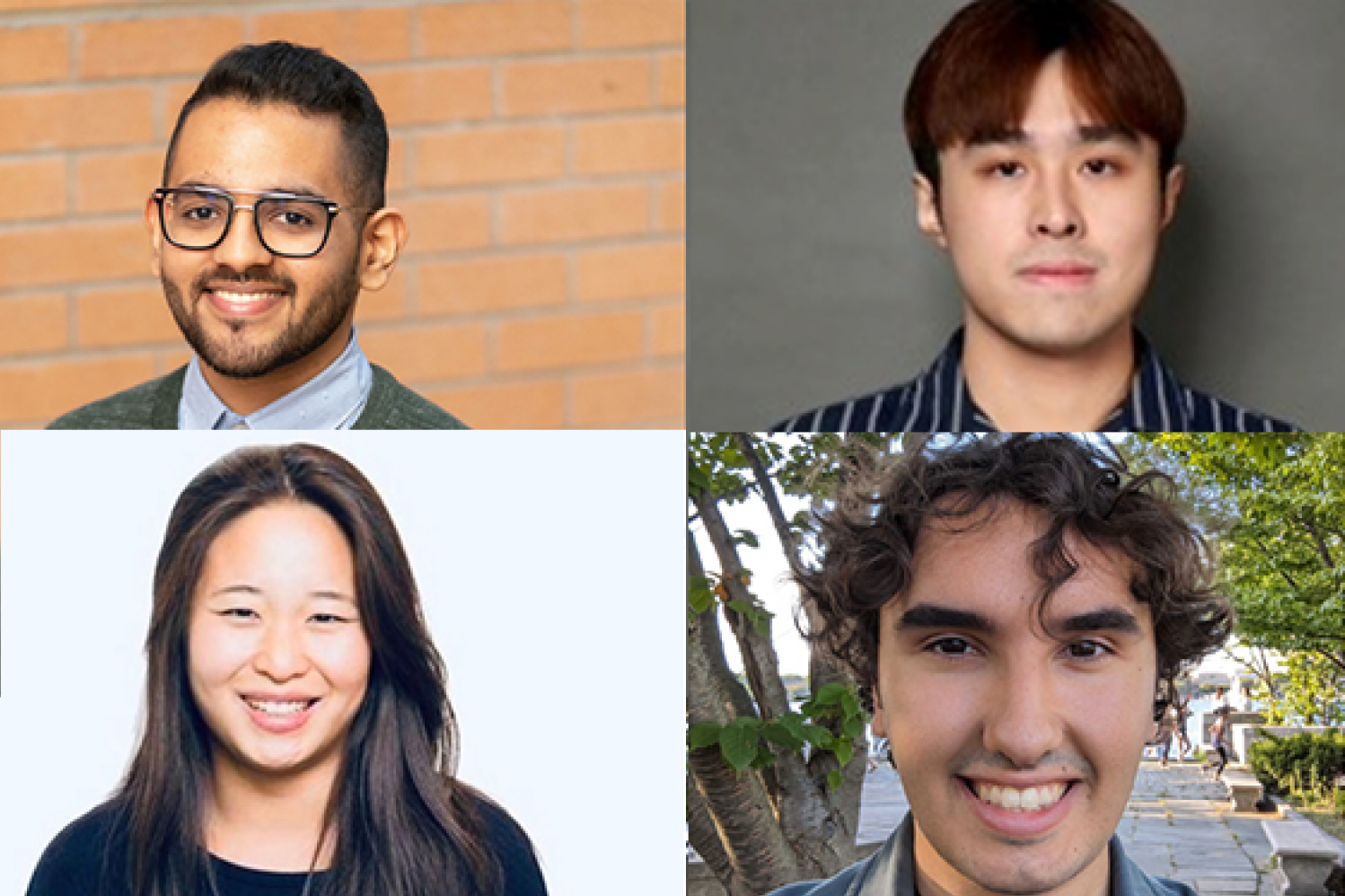

Affinché il linguaggio naturale sia una forma di comunicazione efficace, le parti coinvolte devono essere in grado di comprendere le parole e il loro contesto, presumere che il contenuto sia ampiamente condiviso in buona fede e affidabile, ragionare sulle informazioni condivise e quindi applicarlo a scenari del mondo reale. Gli studenti di dottorato del MIT che stanno effettuando uno stage presso il MIT-IBM Watson AI Lab – Athul Paul Jacob SM ’22, Maohao Shen SM ’23, Victor Butoi e Andi Peng SM ’23 – stanno lavorando per attaccare ogni fase di questo processo integrato nel linguaggio naturale modelli, in modo che i sistemi di intelligenza artificiale possano essere più affidabili e accurati per gli utenti.

Per raggiungere questo obiettivo, la ricerca di Jacob colpisce al cuore i modelli di linguaggio naturale esistenti per migliorare il risultato, utilizzando la teoria dei giochi. I suoi interessi, dice, sono duplici: “Uno è capire come si comportano gli esseri umani, utilizzando la lente dei sistemi multi-agente e la comprensione del linguaggio, e la seconda cosa è: ‘Come puoi usarlo come intuizione per costruire un’intelligenza artificiale migliore?” sistemi?’” Il suo lavoro nasce dal gioco da tavolo “Diplomacy”, in cui il suo gruppo di ricerca ha sviluppato un sistema in grado di apprendere e prevedere i comportamenti umani e negoziare strategicamente per ottenere un risultato ottimale desiderato.

“Questo era un gioco in cui devi creare fiducia; devi comunicare usando il linguaggio. È necessario giocare anche contro altri sei giocatori contemporaneamente, il che era molto diverso da tutti i tipi di compiti che le persone affrontavano in passato”, afferma Jacob, riferendosi ad altri giochi come il poker e GO che i ricercatori hanno inserito nelle reti neurali. . “In tal modo, ci sono state molte sfide di ricerca. Uno era: “Come modelli gli esseri umani?” Come fai a sapere se gli esseri umani tendono ad agire in modo irrazionale?’” Jacob e i suoi mentori di ricerca, tra cui il professore associato Jacob Andreas e il professore assistente Gabriele Farina del Dipartimento di ingegneria elettrica e informatica (EECS) del MIT e del MIT-IBM Watson Yikang Shen di AI Lab: riformula il problema della generazione del linguaggio come un gioco a due giocatori.

Utilizzando modelli “generatore” e “discriminatore”, il team di Jacob ha sviluppato un sistema di linguaggio naturale per produrre risposte alle domande e quindi osservare le risposte e determinare se sono corrette. Se lo sono, il sistema AI riceve un punto; in caso contrario, non viene assegnato alcun punto. I modelli linguistici notoriamente tendono ad avere allucinazioni, rendendoli meno affidabili; questo algoritmo di apprendimento senza rimpianti prende in modo collaborativo un modello di linguaggio naturale e incoraggia le risposte del sistema a essere più veritiere e affidabili, mantenendo le soluzioni vicine ai precedenti del modello linguistico pre-addestrato. Jacob afferma che l’utilizzo di questa tecnica insieme a un modello linguistico più piccolo potrebbe, probabilmente, renderlo competitivo con le stesse prestazioni di un modello molte volte più grande.

Una volta che un modello linguistico genera un risultato, i ricercatori idealmente vogliono che la fiducia nella sua generazione sia in linea con la sua accuratezza, ma spesso non è così. Possono verificarsi allucinazioni con il modello che riporta un’elevata confidenza quando dovrebbe essere bassa. Maohao Shen e il suo gruppo, con i mentori Gregory Wornell, professore di ingegneria di Sumitomo in EECS e ricercatori di laboratorio con IBM Research Subhro Das, Prasanna Sattigeri e Soumya Ghosh, stanno cercando di risolvere questo problema attraverso la quantificazione dell’incertezza (UQ). “Il nostro progetto mira a calibrare i modelli linguistici quando sono scarsamente calibrati”, afferma Shen. Nello specifico, stanno esaminando il problema della classificazione. Per questo, Shen consente a un modello linguistico di generare testo libero, che viene poi convertito in un compito di classificazione a scelta multipla. Ad esempio, potrebbero chiedere al modello di risolvere un problema di matematica e poi chiedergli se la risposta che ha generato è corretta come “sì, no o forse”. Ciò aiuta a determinare se il modello è troppo o poco sicuro di sé.

Automatizzando tutto ciò, il team ha sviluppato una tecnica che aiuta a ottimizzare l’output di fiducia mediante un modello linguistico pre-addestrato. I ricercatori hanno addestrato un modello ausiliario utilizzando le informazioni della verità affinché il loro sistema fosse in grado di correggere il modello linguistico. “Se il tuo modello è troppo sicuro della sua previsione, siamo in grado di rilevarlo e renderlo meno sicuro, e viceversa”, spiega Shen. Il team ha valutato la propria tecnica su numerosi set di dati di benchmark popolari per mostrare quanto bene si generalizza in compiti invisibili per riallineare l’accuratezza e la fiducia delle previsioni del modello linguistico. “Dopo la formazione, puoi semplicemente collegare e applicare questa tecnica a nuove attività senza altra supervisione”, afferma Shen. “L’unica cosa di cui hai bisogno sono i dati per quella nuova attività.”

Victor Butoi migliora anche la capacità del modello, ma invece, il suo team di laboratorio, che comprende John Guttag, il professore di informatica e ingegneria elettrica Dugald C. Jackson presso EECS; i ricercatori di laboratorio Leonid Karlinsky e Rogerio Feris di IBM Research; e gli affiliati del laboratorio Hilde Kühne dell’Università di Bonn e Wei Lin dell’Università di Tecnologia di Graz – sta creando tecniche per consentire ai modelli di linguaggio e visione di ragionare su ciò che vedono e sta progettando suggerimenti per sbloccare nuove capacità di apprendimento e comprendere frasi chiave .

Il ragionamento compositivo è solo un altro aspetto del processo decisionale che chiediamo ai modelli di apprendimento automatico di eseguire affinché possano essere utili nelle situazioni del mondo reale, spiega Butoi. “Devi essere in grado di pensare ai problemi in modo compositivo e risolvere compiti secondari”, dice Butoi, “ad esempio, se dici che la sedia è alla sinistra della persona, devi riconoscere sia la sedia che la persona. Devi capire le indicazioni. E poi, una volta che il modello capisce “sinistra”, il gruppo di ricerca vuole che il modello sia in grado di rispondere ad altre domande che coinvolgono “sinistra”.

Sorprendentemente, i modelli visione-linguaggio non ragionano bene sulla composizione, spiega Butoi, ma possono essere aiutati, utilizzando un modello che possa “guidare il testimone”, se si vuole. Il team ha sviluppato un modello che è stato ottimizzato utilizzando una tecnica chiamata adattamento di basso rango di modelli linguistici di grandi dimensioni (LoRA) e addestrato su un set di dati annotato chiamato Visual Genome, che contiene oggetti in un’immagine e frecce che denotano relazioni, come le direzioni. In questo caso, il modello LoRA addestrato verrebbe guidato a dire qualcosa sulle relazioni “di sinistra”, e l’output della didascalia verrebbe quindi utilizzato per fornire contesto e suggerire il modello visione-linguaggio, rendendolo un “compito notevolmente più semplice”, afferma Butoi. .

Nel mondo della robotica, i sistemi di intelligenza artificiale interagiscono con l’ambiente circostante anche utilizzando la visione e il linguaggio computerizzati. Le ambientazioni possono variare dai magazzini alla casa. Andi Peng e i mentori Julie Shah e Chuang Gan, professori di aeronautica e astronautica del MIT, HN Slater, del laboratorio e dell’Università del Massachusetts ad Amherst, si stanno concentrando sull’assistenza alle persone con limitazioni fisiche, utilizzando mondi virtuali. Per questo, il gruppo di Peng sta sviluppando due modelli di intelligenza artificiale incarnata – un “umano” che ha bisogno di supporto e un agente aiutante – in un ambiente simulato chiamato ThreeDWorld. Concentrandosi sulle interazioni uomo/robot, il team sfrutta i priori semantici catturati da grandi modelli linguistici per aiutare l’intelligenza artificiale aiutante a dedurre quali abilità l’agente “umano” potrebbe non essere in grado di eseguire e la motivazione dietro le azioni dell'”umano”, utilizzando metodi naturali. lingua. Il team sta cercando di rafforzare il processo decisionale sequenziale, la comunicazione bidirezionale, la capacità di comprendere la scena fisica e il modo migliore per contribuire.

“Molte persone pensano che i programmi di intelligenza artificiale dovrebbero essere autonomi, ma penso che una parte importante del processo sia costruire robot e sistemi per gli esseri umani e vogliamo trasmettere la conoscenza umana”, afferma Peng. “Non vogliamo che un sistema faccia qualcosa in modo strano; vogliamo che lo facciano in un modo umano che possiamo comprendere”.

[ad_2]

Source link