[ad_1]

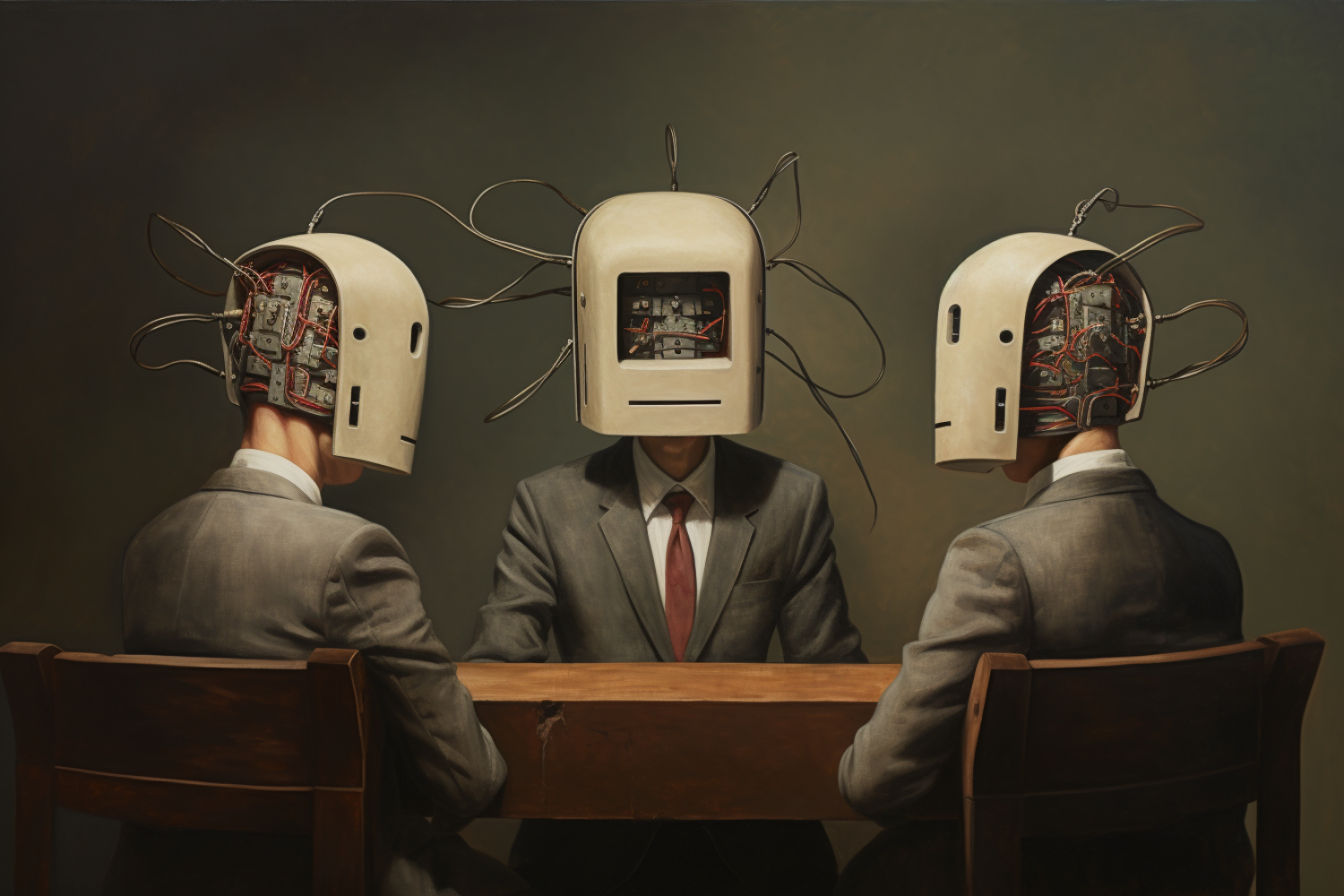

Un vecchio adagio, spesso introdottoci durante i nostri anni formativi, è progettato per spingerci oltre le nostre menti nascenti egocentriche: “Due teste sono meglio di una”. Questo proverbio incoraggia il pensiero collaborativo ed evidenzia la potenza dell’intelletto condiviso.

Avanzando rapidamente fino al 2023, scopriamo che questa saggezza è vera anche nel regno dell’intelligenza artificiale: più modelli linguistici, che lavorano in armonia, sono meglio di uno solo.

Recentemente, un team del Laboratorio di informatica e intelligenza artificiale (CSAIL) del MIT ha incarnato questa antica saggezza all’interno della frontiera della tecnologia moderna. Hanno introdotto una strategia che sfrutta più sistemi di intelligenza artificiale per discutere e discutere tra loro per convergere sulla migliore risposta possibile a una determinata domanda. Questo metodo consente a questi modelli linguistici espansivi di aumentare la loro aderenza ai dati fattuali e affinare il loro processo decisionale.

Il nocciolo del problema con i modelli linguistici di grandi dimensioni (LLM) risiede nell’incoerenza delle risposte generate, che portano a potenziali imprecisioni e ragionamenti imperfetti. Questo nuovo approccio consente a ciascun agente di valutare attivamente le risposte di tutti gli altri agenti e di utilizzare questo feedback collettivo per perfezionare la propria risposta. In termini tecnici, il processo consiste in più cicli di generazione e critica della risposta. Ogni modello linguistico genera una risposta alla domanda data e quindi incorpora il feedback di tutti gli altri agenti per aggiornare la propria risposta. Questo ciclo iterativo culmina in un risultato finale ottenuto da un voto a maggioranza sulle soluzioni dei modelli. Rispecchia in qualche modo la dinamica di una discussione di gruppo, in cui gli individui contribuiscono a raggiungere una conclusione unitaria e ben motivata.

Un vero punto di forza dell’approccio risiede nella sua perfetta applicazione ai modelli a scatola nera esistenti. Poiché la metodologia ruota attorno alla generazione di testo, può anche essere implementata in vari LLM senza bisogno di accedere al loro funzionamento interno. Questa semplicità, afferma il team, potrebbe aiutare ricercatori e sviluppatori a utilizzare lo strumento per migliorare la coerenza e l’accuratezza fattuale dei risultati del modello linguistico su tutta la linea.

“Adottando un approccio innovativo, non ci basiamo semplicemente su un unico modello di intelligenza artificiale per ottenere le risposte. Invece, il nostro processo utilizza una moltitudine di modelli di intelligenza artificiale, ciascuno dei quali apporta approfondimenti unici per affrontare una domanda. Anche se le loro risposte iniziali possono sembrare troncate o contenere errori, questi modelli possono affinare e migliorare le proprie risposte esaminando attentamente le risposte offerte dalle loro controparti,” dice Yilun Du, uno studente di dottorato in ingegneria elettrica e informatica del MIT, affiliato al MIT CSAIL , e autore principale di un nuovo articolo sul lavoro. “Mentre questi modelli di intelligenza artificiale si impegnano nel discorso e nella deliberazione, sono meglio attrezzati per riconoscere e correggere i problemi, migliorare le loro capacità di risoluzione dei problemi e verificare meglio la precisione delle loro risposte. In sostanza, stiamo coltivando un ambiente che li costringa ad approfondire il nocciolo di un problema. Ciò è in contrasto con un modello di intelligenza artificiale unico e solitario, che spesso ripete a pappagallo i contenuti trovati su Internet. Il nostro metodo, tuttavia, stimola attivamente i modelli di intelligenza artificiale a creare soluzioni più accurate e complete.”

La ricerca ha esaminato la risoluzione di problemi matematici, compresi i problemi di matematica delle scuole elementari e medie/superiori, e ha riscontrato un aumento significativo delle prestazioni attraverso il processo di dibattito con più agenti. Inoltre, i modelli linguistici hanno mostrato capacità migliorate di generare valutazioni aritmetiche accurate, illustrando il potenziale in diversi domini.

Il metodo può anche aiutare ad affrontare il problema delle “allucinazioni” che spesso affliggono i modelli linguistici. Progettando un ambiente in cui gli agenti criticano a vicenda le risposte degli altri, sono stati maggiormente incentivati a evitare di fornire informazioni casuali e a dare priorità all’accuratezza fattuale.

Oltre alla sua applicazione ai modelli linguistici, l’approccio potrebbe essere utilizzato anche per integrare diversi modelli con capacità specializzate. Stabilendo un sistema decentralizzato in cui più agenti interagiscono e discutono, potrebbero potenzialmente utilizzare queste capacità di risoluzione dei problemi complete ed efficienti attraverso varie modalità come parlato, video o testo.

Sebbene la metodologia abbia prodotto risultati incoraggianti, i ricercatori affermano che i modelli linguistici esistenti potrebbero dover affrontare sfide con l’elaborazione di contesti molto lunghi e le capacità critiche potrebbero non essere raffinate come desiderato. Inoltre, il formato del dibattito multi-agente, ispirato all’interazione del gruppo umano, deve ancora incorporare le forme più complesse di discussione che contribuiscono a un processo decisionale collettivo intelligente, un’area cruciale per l’esplorazione futura, afferma il team. Il progresso della tecnica potrebbe comportare una comprensione più profonda delle basi computazionali alla base dei dibattiti e delle discussioni umane e l’utilizzo di tali modelli per migliorare o integrare i LLM esistenti.

“Non solo questo approccio offre un percorso per elevare le prestazioni dei modelli linguistici esistenti, ma presenta anche un mezzo automatico di auto-miglioramento. Utilizzando il processo di dibattito come dati supervisionati, i modelli linguistici possono migliorare la loro fattualità e il ragionamento in modo autonomo, riducendo fare affidamento sul feedback umano e offrire un approccio scalabile all’auto-miglioramento”, afferma Du. “Mentre i ricercatori continuano a perfezionare ed esplorare questo approccio, possiamo avvicinarci a un futuro in cui i modelli linguistici non solo imitano il linguaggio umano, ma mostrano anche un pensiero più sistematico e affidabile, dando vita a una nuova era di comprensione e applicazione del linguaggio.”

“È molto logico utilizzare un processo deliberativo per migliorare il risultato complessivo del modello, ed è un grande passo avanti rispetto alla catena di pensiero”, afferma Anca Dragan, professore associato presso il Dipartimento di Ingegneria Elettrica dell’Università della California a Berkeley. e Informatica, che non è stata coinvolta nel lavoro. “Sono entusiasta di dove questo potrà andare dopo. Le persone possono giudicare meglio le risposte che escono dai LLM quando vedono la deliberazione, se converge o meno? Le persone possono arrivare a risposte migliori da sole deliberando con un LLM? Può un approccio simile idea può essere utilizzata per aiutare un utente a sondare la risposta di un LLM per arrivare a una migliore?”

Du ha scritto l’articolo con tre affiliati CSAIL: Shuang Li SM ’20, PhD ’23; Antonio Torralba, professore di Ingegneria Elettrica e Informatica del MIT; e Joshua Tenenbaum, professore di scienze cognitive computazionali del MIT e membro del Center for Brains, Minds, and Machines. Anche il ricercatore di Google DeepMind Igor Mordatch è stato coautore.

[ad_2]

Source link